金砖国家即将遭到报复?专家预测美国关税后果

人工智能已经改变了许多领域的游戏规则,从医疗保健到零售再到娱乐和艺术。然而,新的研究表明,我们可能已经达到了一个转折点:AI 从 AI 生成的内容中学习。

这个 AI 衔尾蛇——一条吃自己尾巴的蛇——可能会有很糟糕的结局。来自英国不同大学的一个研究小组就他们所谓的“模型崩溃”发出了警告,这是一种可以将人工智能与现实完全分离的退化过程。

来自剑桥大学和牛津大学、多伦多大学以及伦敦帝国理工学院的研究人员在一篇题为“递归的诅咒:生成数据的训练使模型忘记”的论文中解释说,当“生成的数据最终污染了训练”时,模型崩溃就会发生下一代模型的集合,”他们写道。“在被污染的数据上接受训练,他们就会错误地感知现实。”

换句话说,人工智能在生成在线内容中的广泛使用可能会污染用于训练它们的数据,从而导致失真和不准确。

这个问题已经在一系列学习生成模型和工具中被发现,包括大型语言模型 (LLM)、变分自动编码器和高斯混合模型。随着时间的推移,模型开始“忘记真正的底层数据分布”,导致对现实的不准确表示,因为原始信息变得如此扭曲以至于它不再像真实世界的数据。

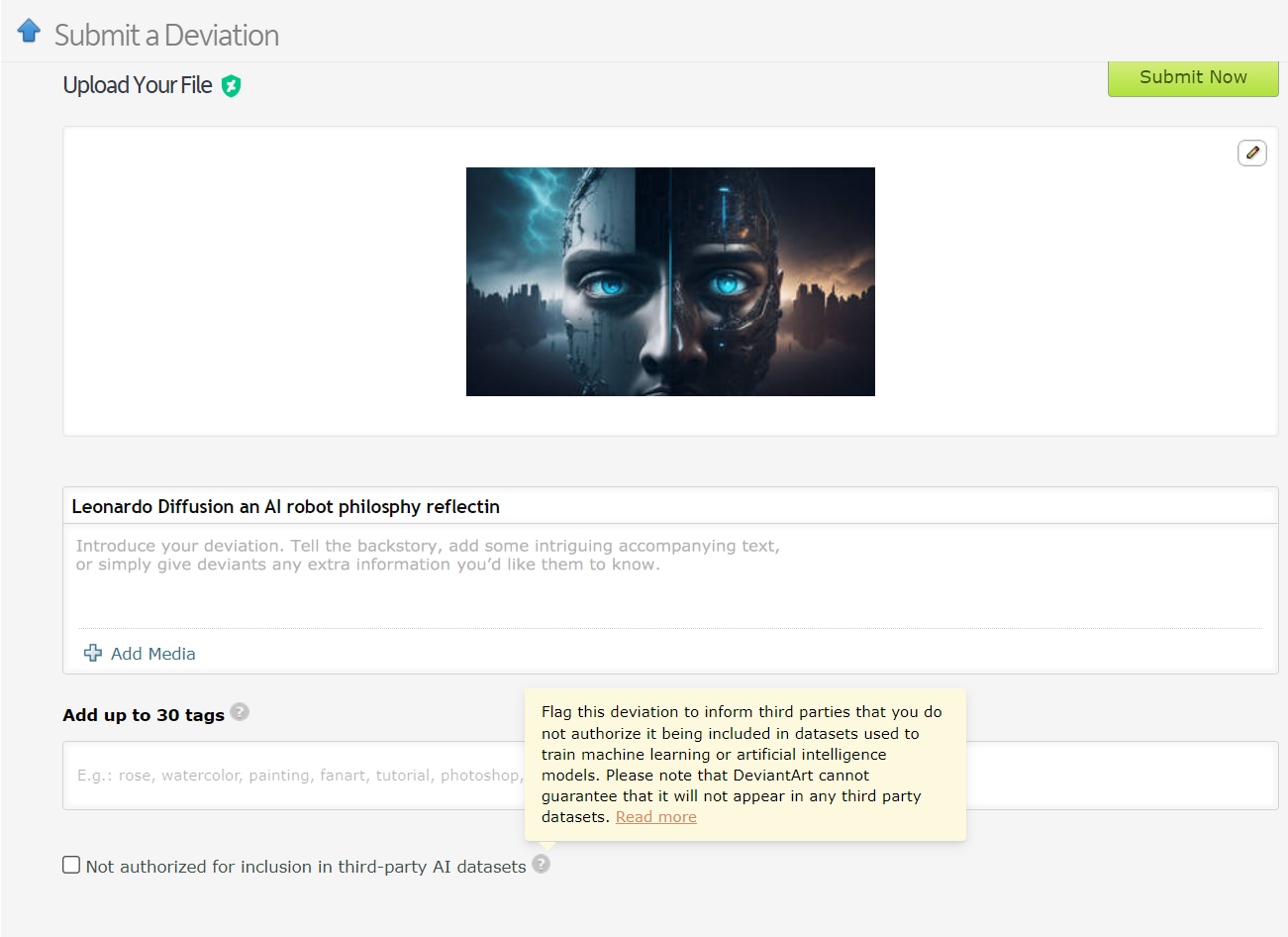

已经有机器学习模型在 AI 生成的数据上进行训练的实例。例如,语言学习模型 (LLM) 正在根据GPT-4 的输出进行有意训练。同样,艺术家在线平台 DeviantArt 允许发布 AI 创作的艺术作品,并将其用作更新 AI 模型的训练数据。

就像试图无限期地复制或克隆某些东西一样,根据研究人员的说法,这些做法可能会导致更多的模型崩溃实例。

鉴于模型崩溃的严重影响,访问原始数据分布至关重要。AI 模型需要真实的、人工生成的数据来准确理解和模拟我们的世界。

根据研究论文,模型崩溃的主要原因有两个。第一个是“统计近似误差”,它与有限数量的数据样本有关。第二个是“函数逼近误差”,它源于人工智能训练期间使用的误差范围没有正确配置。这些错误可能会代代相传,导致不准确性恶化的级联效应。

该论文阐明了训练 AI 模型的“先发优势”。如果我们能够保持对原始人工生成数据源的访问,我们就可以防止有害的分布转移,从而防止模型崩溃。

然而,大规模区分 AI 生成的内容是一项艰巨的挑战,这可能需要社区范围内的协调。

归根结底,数据完整性的重要性和人类信息对 AI 的影响取决于它所来自的数据,而 AI 生成的内容的爆炸式增长最终可能成为该行业的一把双刃剑。这是“输入垃圾,输出垃圾”——基于 AI 内容的 AI 将产生许多非常聪明但“有幻想”的机器。

具有讽刺意味的情节转折如何?我们的机器后代从彼此身上学到的东西比从我们身上学到的更多,因此变得“妄想”。接下来,我们将不得不处理一个妄想的、青春期的 ChatGPT。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。本站资讯仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

industry-frontier