金砖国家即将遭到报复?专家预测美国关税后果

斯坦福大学的研究人员最近得出结论,目前在AI工具中使用的大型语言模型(LLMS)没有一个是符合欧盟的。 《人工智能法》 .

该法案是在国家和区域一级管理大赦国际的第一部此类法案,刚刚获得欧洲议会通过。… 欧盟大赦国际法 不仅在欧盟内部监管涵盖4.5亿人口的人工智能,而且也是全球人工智能条例的开拓性蓝图。

但是,根据斯坦福大学的最新研究,如果人工智能公司想要达到合规的目标,他们还有很长的路要走。

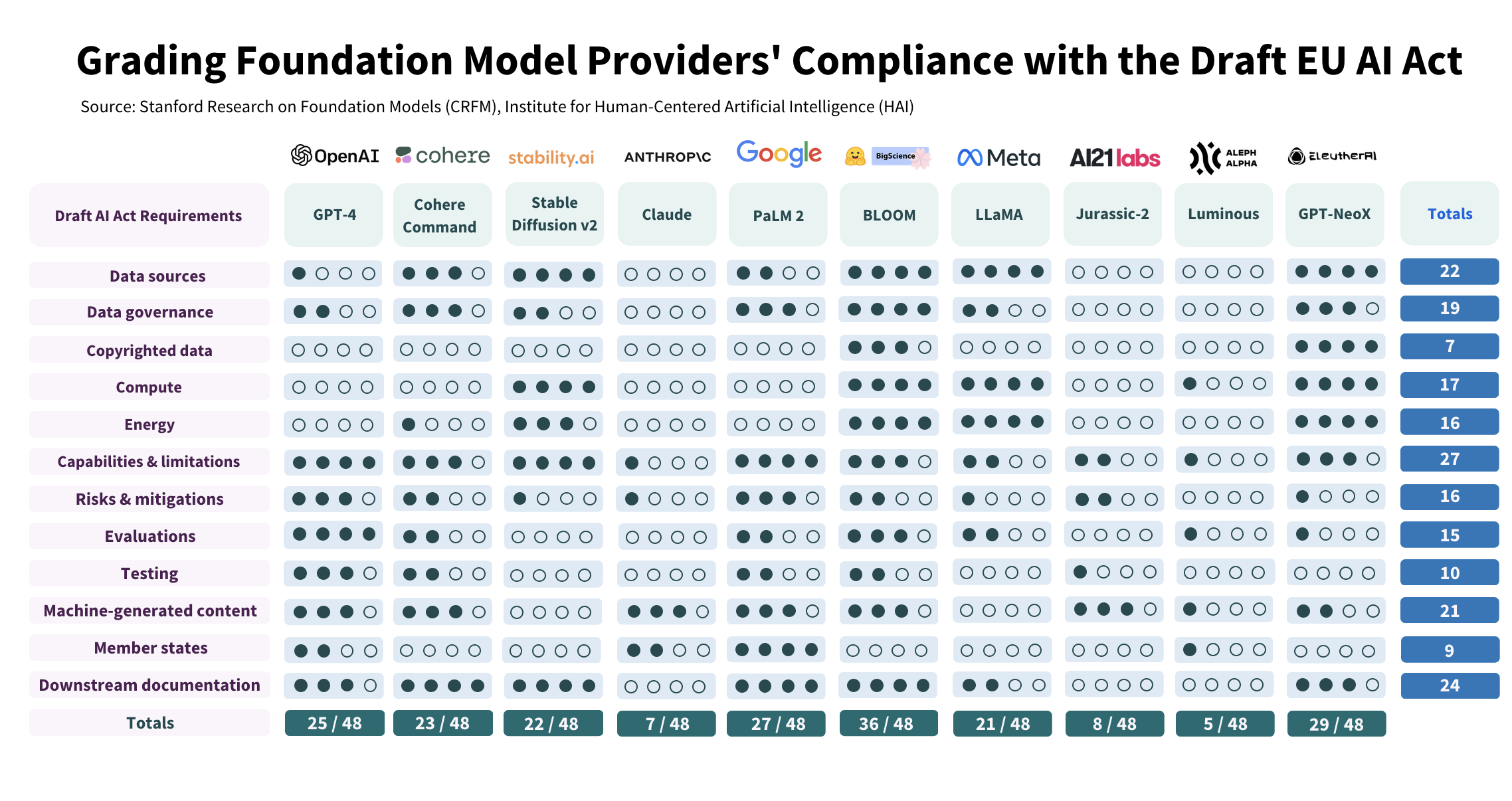

在他们的 调查 ,研究人员评估了十个主要的模型供应商。他们以0至4个尺度评估了每个供应商遵守《人工智能法》中概述的12项要求的程度。

该研究揭示了在遵守水平上的巨大差异,一些提供者在满足AI法案要求时得分低于25%,只有一个提供者,拥抱脸/大科学,得分高于75%。

显然,即使对得分高的供应商来说,也有显著改进的余地。

这项研究揭示了不遵守的一些关键问题。研究人员写道,在披露受版权保护的培训数据、使用的能源、产生的排放量以及降低潜在风险的方法方面缺乏透明度是最令人担忧的发现。

此外,小组发现开放版和封闭版之间存在明显差异,开放版导致更有力地披露资源,但涉及更大的挑战监测或控制部署。

斯坦福的结论是,所有的供应商都可以提高他们的行为,不管他们的释放策略如何。

近几个月来,主要型号版本的透明度明显降低。例如,该公司在其关于GTP-4的报告中没有披露数据和计算,并列举了竞争环境和安全影响。

虽然这些结论意义重大,但也符合更广泛的发展叙述。最近,公开赛一直在游说,以影响各国对大赦国际的立场。科技巨头甚至 他威胁要离开欧洲 如果规定过于严格--这种威胁后来被取消了。这些行动突出了人工智能技术供应商与监管机构之间复杂且往往令人担忧的关系。

研究人员提出了几项改进人工智能监管的建议.对欧盟决策者而言,这包括确保《大赦法》为更大的基础模型提供者提供问责,以确保透明度和问责制。还强调需要技术资源和人才来执行该法,这反映了人工智能生态系统的复杂性。

研究人员认为,主要的挑战在于模型供应商如何迅速适应和发展其业务做法,以满足监管要求。他们观察到,在没有强大的监管压力的情况下,许多供应商可以通过有意义但可信的变化,在30或40岁(可能的48分中)达到总分。

研究人员的工作对人工智能的未来提供了一个深刻的展望.他们认为,如果颁布和执行《大赦法》,将对生态系统产生重大的积极影响,为提高透明度和加强问责铺平道路。

大赦国际正在以其前所未有的能力和风险改变社会。随着世界正处在规范这一改变游戏的技术的顶端,越来越清楚的是,透明度不仅仅是一个可选择的附加物--它是负责任的AI部署的基石。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。本站资讯仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

industry-frontier