金砖国家即将遭到报复?专家预测美国关税后果

在人工智能艺术创作工具的快速发展中,英伟达的研究人员推出了一种名为灌注的创新文本到图像个性化方法。但它不像竞争对手那样是价值百万美元的超重量级车型。Perfusion的大小仅为100KB,训练时间为4分钟,在描绘个性化概念的同时保持其身份,具有极大的创造性灵活性。

灌注在英伟达和以色列特拉维夫大学撰写的一篇研究论文中进行了介绍。尽管体积很小,但它在特定版本的效率方面能够超越领先的AI艺术生成器,如Stability AI的Stable Diffusion v1.5,新发布的Stable Diffusion XL(SDXL)和MidJourney。

灌注的主要新思想被称为“钥匙锁定”。这是通过在图像生成过程中将用户想要添加的新概念(如特定的猫或椅子)连接到更通用的类别来工作的。例如,猫将与更广泛的“猫科动物”概念联系起来。

这有助于避免过度拟合,即模型过于狭隘地调整到确切的训练示例。过度拟合使AI难以生成概念的新创意版本。

通过将新猫与猫科动物的一般概念联系起来,该模型可以以许多不同的姿势、外观和环境描绘猫。但它仍然保留了基本的“猫性”,使它看起来像预定的猫,而不仅仅是任何随机的猫科动物。

因此,简单来说,钥匙锁定可以让AI灵活地描绘个性化概念,同时保持其核心身份。这就像给艺术家以下指示:“画我的猫汤姆,在睡觉、玩毛线和嗅花的时候。

灌注还可以将多个个性化概念组合在具有自然交互的单个图像中,这与孤立学习概念的现有工具不同。用户可以通过文本提示指导图像创建过程,合并特定的猫和椅子等概念。

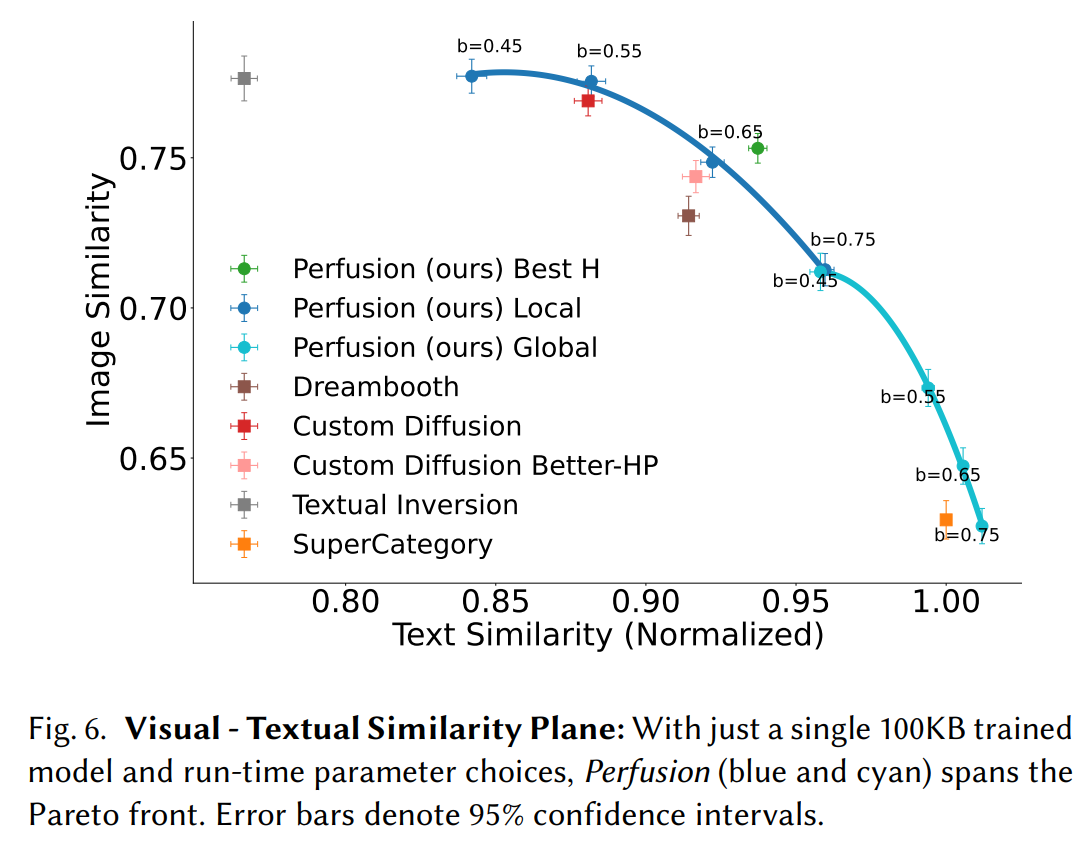

灌注提供了一个显着的功能,允许用户通过调整单个 100KB 模型来控制推理过程中视觉保真度(图像)和文本对齐(提示)之间的平衡。此功能允许用户轻松探索帕累托前沿(文本相似性与图像相似性),并选择适合其特定需求的最佳权衡,所有这些都无需重新训练。重要的是要注意,训练模型需要一些技巧。过多地专注于复制模型会导致模型一遍又一遍地产生相同的输出,并且使其过于紧密地遵循提示而没有自由,通常会产生不好的结果。调整生成器与提示的接近程度的灵活性是重要的自定义部分

其他AI图像生成器有办法让用户微调输出,但它们体积庞大。作为参考, LoRA 是稳定扩散中使用的一种流行的微调方法.它可以向应用程序添加从数十兆字节到超过一千兆字节 (GB) 的任何内容。另一种方法,文本反转嵌入,更轻,但不太准确。使用目前最精确的技术Dreambooth训练的模型重量超过2GB。

相比之下,英伟达表示,与前面提到的领先的人工智能技术相比,Perfusion产生了卓越的视觉质量和与提示的对齐。与微调整个模型的方法的多 GB 占用空间相比,超高效的尺寸使得在微调生成图像的方式时只需更新所需的部分成为可能。

这项研究与英伟达对人工智能的日益关注相一致。该公司的股票在 230 年飙升了 2023% 以上,因为其 GPU 继续主导训练 AI 模型。随着Anthropic,Google,Microsoft和百度等实体向生成AI投入数十亿美元,Nvidia的创新灌注模型可能会给它带来优势。

英伟达目前只提交了研究论文,承诺很快就会发布代码。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。本站资讯仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

industry-frontier